Introdução

A dissolução da equipe de riscos de IA na OpenAI levantou sérias preocupações sobre a segurança e o futuro da inteligência artificial. Com a saída de importantes pesquisadores e a reorganização interna, surgem muitas questões sobre as prioridades e a direção da empresa. Neste artigo, vamos explorar os detalhes dessa decisão, suas implicações e o que isso significa para o desenvolvimento de IA segura.

Formação da Equipe de Super Alinhamento

Anúncio Inicial

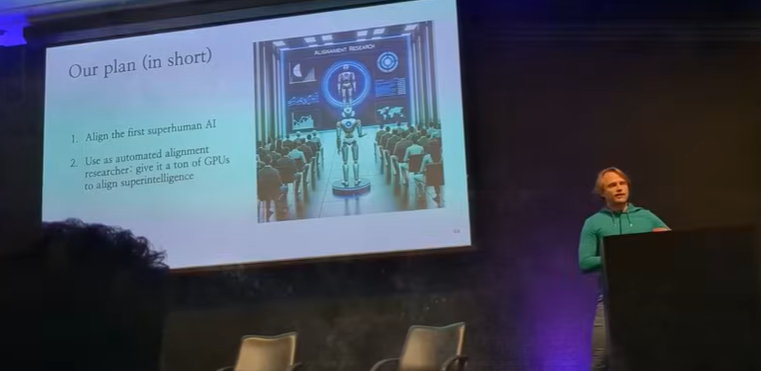

Em julho do ano passado, a OpenAI anunciou a formação de uma nova equipe de pesquisa chamada de Super Alinhamento, co-liderada pelo cofundador e cientista-chefe Ilia Sutskever. Esta equipe tinha como missão dedicar 20% do poder computacional da OpenAI para garantir que os futuros desenvolvimentos de IA permanecessem sob controle humano e alinhados com os valores humanos.

Objetivos da Equipe

A equipe de Super Alinhamento foi criada para:

- Segurança: Garantir que as IAs futuras sejam seguras e não apresentem comportamentos inesperados ou perigosos.

- Alinhamento: Assegurar que as IAs atuem de acordo com os valores humanos e beneficiem a sociedade como um todo.

- Supervisão: Monitorar continuamente os sistemas de IA para detectar e corrigir quaisquer desvios indesejados.

A Dissolução da Equipe

Saída de Ilia Sutskever

A dissolução da equipe começou com a saída de Ilia Sutskever, que foi um dos membros fundadores da OpenAI. Ele desempenhou um papel crucial na direção da pesquisa que levou a avanços como o ChatGPT. Sua saída foi inesperada e levantou muitas questões sobre a estabilidade e as prioridades internas da OpenAI.

Crise de Governança

A situação se complicou ainda mais quando Sutskever, junto com outros três membros do conselho, demitiu o CEO Sam Altman. Este movimento causou um tumulto interno, levando a uma revolta entre os funcionários. Após cinco dias caóticos, Altman foi reintegrado como CEO, e Sutskever, junto com outros dois membros do conselho, deixou a empresa.

Saída de Jan Leike

Poucas horas após a saída de Sutskever, Jan Leike, o outro co-líder da equipe de Super Alinhamento, anunciou sua renúncia. Leike explicou sua decisão na plataforma X, citando discordâncias sobre as prioridades da empresa e a alocação de recursos. Ele mencionou que, nos últimos meses, sua equipe estava “navegando contra o vento”, lutando por poder computacional e encontrando cada vez mais dificuldades para realizar pesquisas cruciais.

Saídas Adicionais

Após a crise de governança em novembro do ano passado, mais informações surgiram:

- Leopold Aschenbrenner e Pavle Isof: Foram demitidos por vazarem segredos da empresa.

- William Saunders: Deixou a empresa em fevereiro.

- Cullen O’Keefe: Liderou a pesquisa em políticas e saiu em abril.

- Daniel Kotow: Co-escreveu artigos sobre os riscos de IA avançada e também saiu, citando preocupações sobre a direção da empresa.

Impactos no Futuro da IA

Prioridades Internas

A dissolução dessa equipe crítica levanta preocupações sobre a segurança e o alinhamento de futuras IAs. Uma das críticas recorrentes é que a liderança da OpenAI parece estar mais focada no desenvolvimento de produtos e novas funcionalidades do que na segurança e alinhamento da IA. Jan Leike mencionou que estava discordando da liderança da OpenAI há algum tempo sobre as prioridades da empresa.

Vozes de Alerta

Ilia Sutskever, em sua postagem de despedida, expressou confiança na trajetória da OpenAI sob a liderança atual, mas não explicou sua decisão de sair. Por outro lado, Leike foi mais explícito, falando sobre a necessidade urgente de controlar sistemas de IA que são muito mais inteligentes do que nós. Esta urgência é algo que não deve ser ignorado.

Conquistas da Equipe de Super Alinhamento

Durante seu tempo na OpenAI, a equipe de Leike alcançou marcos significativos na pesquisa de IA:

- InstructGPT: Primeiro modelo de aprendizado por reforço com feedback humano.

- Supervisão Escalável: Publicação da primeira supervisão escalável em modelos de linguagem de grande escala.

- Interpretabilidade Automatizada: Pioneiros em interpretabilidade automatizada.

- Generalização de Fraca a Forte: Avanços na generalização de fraca a forte.

O Desafio do Equilíbrio Entre Inovação e Segurança

A saída de Leike e suas preocupações destacam um problema crucial na indústria de IA: o equilíbrio entre inovação e segurança. A OpenAI, como muitas outras empresas de tecnologia, está em uma corrida para desenvolver sistemas de IA mais avançados. Esta corrida não é apenas sobre avanços tecnológicos, mas também sobre dominância de mercado. Em um ambiente onde o vencedor leva tudo, a pressão para inovar rapidamente pode, às vezes, sobrepor-se à necessidade de testes de segurança rigorosos.

FAQ

Por que a equipe de riscos de IA foi dissolvida?

A equipe foi dissolvida devido a discordâncias internas sobre as prioridades da empresa e a alocação de recursos. Saídas de alto perfil e questões de governança também contribuíram para a decisão.

Quem era Ilia Sutskever?

Ilia Sutskever é cofundador e cientista-chefe da OpenAI, e foi instrumental na direção da pesquisa que levou a avanços como o ChatGPT. Ele também estava envolvido na decisão de demitir o CEO Sam Altman, o que gerou uma crise interna.

O que isso significa para a segurança da IA?

A dissolução da equipe de riscos de IA pode indicar que a segurança e o alinhamento estão recebendo menos atenção, o que pode ser perigoso à medida que as IAs se tornam mais avançadas. Há preocupações de que a prioridade esteja sendo dada ao desenvolvimento de produtos em vez de garantir que as IAs sejam seguras e alinhadas com valores humanos.

Quais foram as conquistas da equipe de Super Alinhamento?

A equipe alcançou vários marcos, incluindo o lançamento do primeiro modelo de aprendizado por reforço com feedback humano, InstructGPT, a publicação da primeira supervisão escalável em modelos de linguagem de grande escala, pioneiros em interpretabilidade automatizada e avanços na generalização de fraca a forte.

Conclusão

A saída dos principais pesquisadores e a dissolução da equipe de riscos de IA na OpenAI são um alerta. É crucial prestar atenção às preocupações levantadas por especialistas e defender o desenvolvimento responsável da IA. O equilíbrio entre inovação e segurança deve ser cuidadosamente mantido para garantir que as IAs futuras sejam benéficas e seguras para a sociedade. À medida que a OpenAI e outras empresas continuam a avançar no campo da inteligência artificial, a transparência e a responsabilidade devem ser prioritárias para evitar consequências imprevistas e potencialmente perigosas.